AIと学術の交差点:LLMの倫理的課題を考える

近年の人工知能(AI)の進展は、大きな期待と同時に不安も呼び起こしています。生成AI、特にオリジナルコンテンツを簡単に生成できる大規模言語モデル(LLM)を用いたチャットボットは、広く議論されています。多くの人が、それらが良くも悪くも使い方次第であることを認識しています。

中でも懸念が広がっているのが、学術界と教育分野です。ChatGPTのようなプログラムは研究に役立つツールである一方で、教育倫理や学術的誠実性に関する多くの課題も抱えています。

ここでは、LLMの仕組みと、学術界におけるAIの倫理的な考慮点について詳しく見ていきます。

仕組みの概要

ChatGPTのようなLLM AIモデルは、自然言語処理を用いて人間が作成したテキストのパターンを分析・学習します。これらは多様なトピックを含む大規模なデータセットで訓練されているため、包括的でよく調査されたように見える回答を生成することができます。

通常はチャットボットの形をとり、ユーザーが入力したさまざまなプロンプトに対して迅速に応答を生成できます。その結果は人間の応答とほとんど区別がつかないほどです。これらのモデルは、複数の視点から物事を考察しているように見えるテキストを生成する能力があります。

具体的には、質問への回答、アイデアの創出、文章の要約、翻訳、全文生成などに使用できます。

ブラックボックス問題

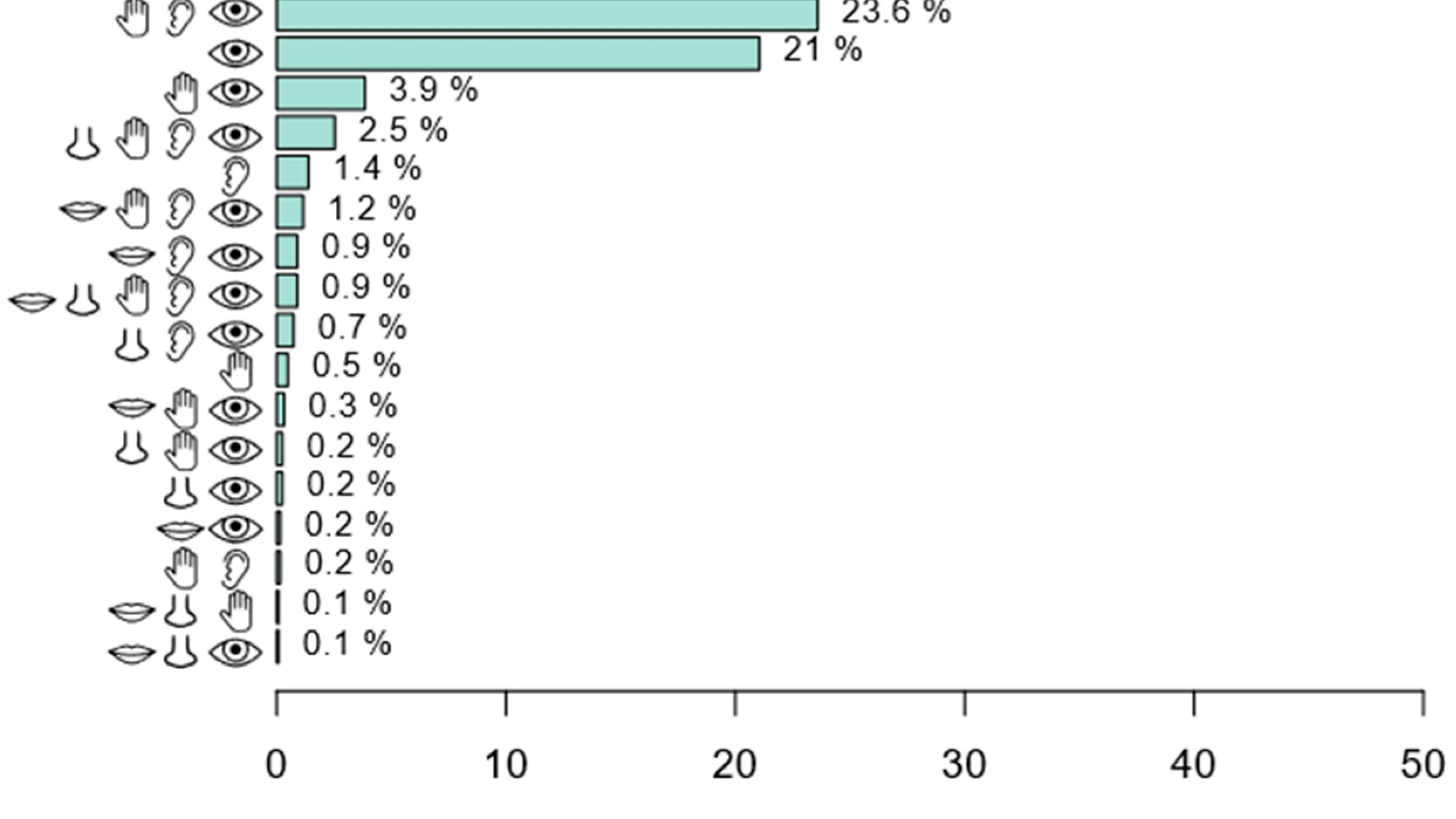

ブラックボックス問題は、AI分野で最も懸念されている問題の1つです。ブラックボックスとは、入力と出力はわかっていても、出力を導く過程が不明である問題を指します。

AIにおいては、検討すべきパラメータを設定し、出力結果を見ることは可能ですが、その結論に至る手法を私たちは理解できません。この透明性の欠如により、AIのアルゴリズムは解釈できず、意思決定に使われても、そのプロセスは不明のままです。

AIが訓練されるデータセットには多くのバイアスが含まれています。人間によって書かれた文書には、意見や不公正、誤解が入り込みやすいため、AIの出力にもバイアスが反映される恐れがあります。

そのため、AIモデルの透明性や解釈可能性、説明可能性に関する研究も進められています。

学術界におけるAIの倫理的考慮点

LLMは、複雑な文章の要約、プロンプトの生成、反復的で時間のかかる事務作業の処理、データ分析など、研究や学習を支援する多くの用途があります。

しかし、エッセイや論文全文の生成にも使用できるため、学術的誠実性の観点から大きな懸念が持たれています。これは学生や研究者の能力にも影響する可能性があります。

以下では、学術分野における生成AIの利用に関して、いくつかの倫理的視点を紹介します。

バイアス、公平性、透明性

公平性を守り、AIが社会的なステレオタイプを強化しないようにすることが重要です。しかしブラックボックス問題により、これを実現するのは困難です。

そのため、研究者がAIを用いて学術資料を作成することで、意図せずにバイアスを含んだ研究や意見を助長したり、完全に作り話の情報を拡散することもありえます。

また、意思決定の自動化がバイアスの影響を受けやすいという問題もあります。たとえば、銀行の融資、司法制度、採用、大学入試などにおいて不公平な扱いが発生する可能性があります。

誤情報

LLMは、データベースを検索し、最も適切な結果や確率に基づいて推測を行うことで情報を提供するよう設計されています。検索エンジンとは異なり、関連する情報源の一覧を提示して読者に判断を委ねるのではなく、その結論をあたかも事実のように提示します。

学術界では、情報源を厳密に参照・検証することが必須であるため、これは大きな問題となります。情報源に触れずにLLMの出力をそのまま鵜呑みにすることで、誤情報の拡散につながる恐れがあります。

ChatGPTが、自分自身のアイデアを研究成果として提示した例も多数報告されています。人間が作成した誤情報に信憑性を与えるだけでなく、AI自身が捏造した研究結果を分野を問わず提供してしまうこともあります。

AIが研究者に与える影響

研究業務の自動化が進む中で、研究スキルの低下を懸念する声もあります。時間や労力の節約という点では魅力的ですが、将来の研究者がLLMに依存することで、研究の質や能力が低下する可能性があるとされています。

アカデミックライティング

学術的な能力において特に重要なのが、書く力=文章による表現力です。ChatGPTのようなLLMを使ってエッセイの一部または全文を作成する学生がいることは、信頼性のある研究を行うための基本的な能力の養成という観点からも問題となる可能性があります。

MDPIにおける著者とAIの扱い

MDPIは、研究倫理と、原稿作成におけるAIおよびAI支援技術の倫理的利用に取り組んでいます。著者は、これらのツールを使用した場合は、その使用方法を明確に開示し、ツールの製品情報を併記することが求められます。

また、著者は自身の原稿がMDPIの出版倫理ポリシーに準拠していることを保証する責任があります。MDPIにおける著者とAIについてはこちらをご覧ください。

学術と教育におけるAIの未来

AIは、教育や研究のさまざまな場面において大きな可能性を秘めていますが、その利用には慎重さが求められます。

現時点では、LLMは訓練されたデータに依存しており、その結論が科学的に正確または妥当である保証はありません。AIを偏見なく適切に使用するための規制やツールの開発が必要です。

※本記事はMDPIの英語ブログを元に作成したものです。元記事はこちら。