AIは知性を持てるか─汎用人工知能に関する議論

AIツールの進化スピードは凄まじく、AIが人間よりも賢くなる可能性について興奮と懸念が入り混じった議論を引き起こしています。ChatGPTのようなツールを「汎用人工知能(AGI: Artificial General Intelligence)」と呼ぶ人もいますが、それは曖昧で革命的な概念であり、さまざまな解釈がなされています。

AGIとは、人間と同等の知能を持ち、人間と同じようにタスクをこなせるAIのことを指します。しかし、人間の知能自体も定義が難しいのです。この記事では、知能という概念の対立する定義と、それがAIにどう関係するかを考察します。さらに、AGIとは何か、ChatGPTがAGIに近づいているという主張、AGIの姿、そしてそれにまつわる懸念についても探っていきます。

人工知能

AIとは、計算機科学を活用して大規模なデータセットを処理し、問題を解決する分野です。一般的な活用例には、データの整理・分類、新しいデータの生成、パターンの認識など、無数の用途があります。

「AI(人工知能)」という言葉自体、その仕組みについての手がかりを与えてくれます。「人工」とは単に人間によって作られたもの、しばしば自然のものを模倣したものを意味します。この場合は人間の知能の模倣です。

AIとは、人間の知能を模倣するように訓練されたものと考えるとよいでしょう。人間の知能そのものを再現しているわけではなく、人間がある目標を達成するために用いるパターンや方法を再現しようとしているのです。

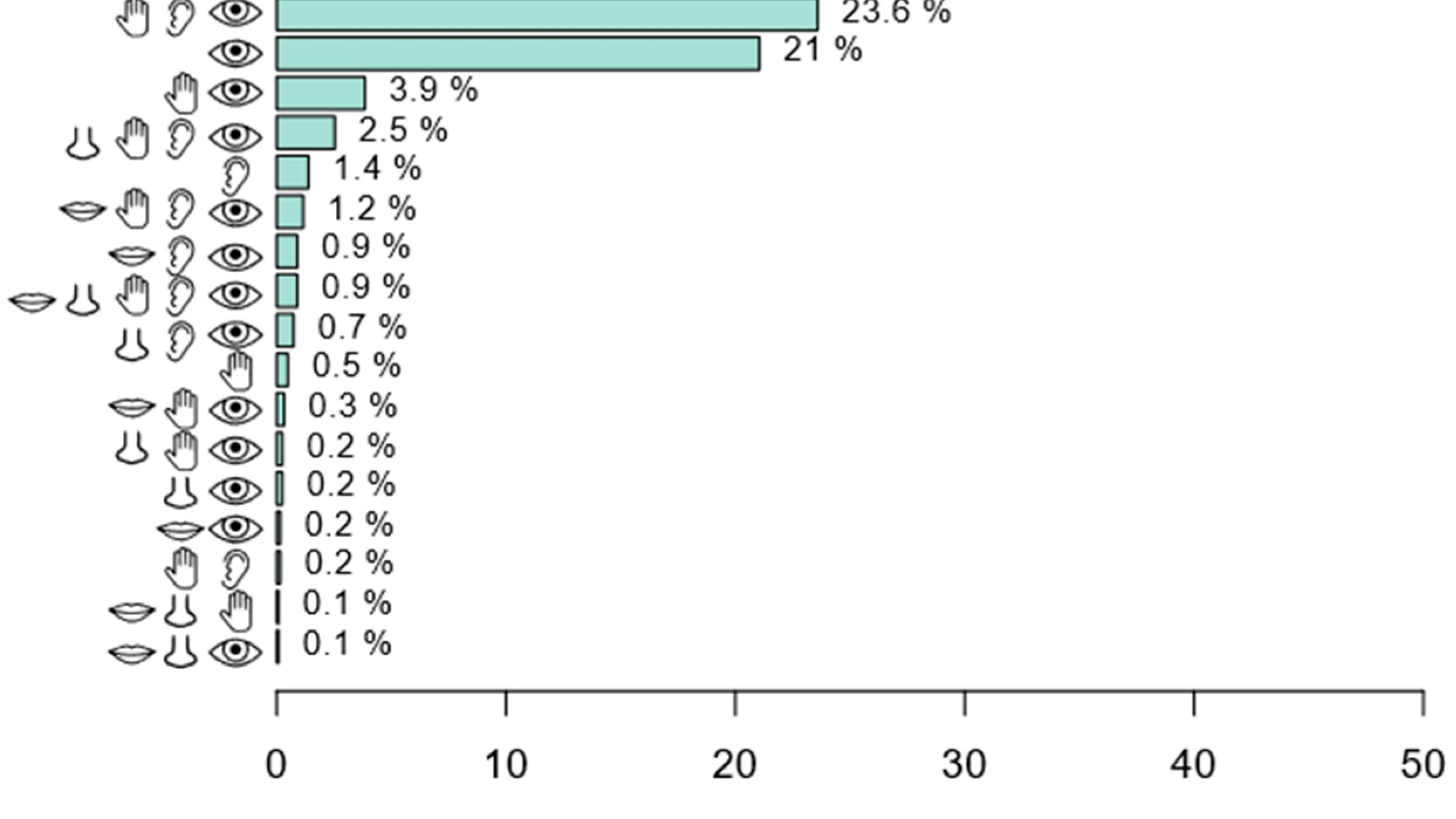

さらに、すべてのAIツールの背後には膨大な人間の労働力があります。こうした作業者たちはアノテーターと呼ばれ、データにタグを付けたり、画像にラベルを付けたり、カメラの前で表情を演じたりしています。機械に現実を簡略化して伝えるには、人間側で非常に複雑な作業が必要で、完全な一貫性が求められます。明らかに、人間の知能が人工知能の基盤となっているのです。

ChatGPTの自然な会話スタイルは、複数回にわたる人間によるアノテーションによって可能となっています。これは「人間のフィードバックによる強化学習」と呼ばれます。

知能とは何か?

AIツールは人間の手によって実現されています――では、人間の知能とは何なのでしょうか?

この用語は、学ぶ、理解する、判断を下す、意見を持つといった、理性に基づいた能力として定義されています。つまり、単一の能力ではなく、幅広いプロセスを包含する概念なのです。このため、知能の定義はしばしば激しく議論されます。

たとえば、2人の人がまったく共通点がないにもかかわらず、どちらも「知的」と見なされることがあります。1人目はある特定のスキルセットによって知的とされ、もう1人は別のスキルによって知的とされるのです。このように、スキルが重複していなくても、どちらも「知的」と評価されうるのです。

ここで登場するのが「一般知能(general intelligence)」という概念です。

一般知能

この「一般知能」は、知能の曖昧さを整理するために生まれた考え方です。

イギリスの心理学者チャールズ・スピアマンは、知能を測定するテストを設計しました。彼は、あるテストで良い成績を取る人は他のテストでも良い結果を出し、逆に1つのテストで悪い結果の人は他でも悪かった、という傾向を見出しました。

彼は、知能とは数値的に測定可能な一般的な能力であると結論づけました。つまりIQのような尺度で表現できるということです。

一般知能とは、さまざまな認知能力に影響を与える幅広い精神的能力の存在と定義されます。

これは運動能力と似ています。優れたランナーが必ずしもサッカーが上手とは限りませんが、身体的に鍛えられているため、運動不足の人よりもサッカーの試合で良いパフォーマンスを見せる可能性があります。

とはいえ、IQテストなどには根本的な欠陥があり、感情的、空間的、対人関係的な知能など多くの側面を無視しています。したがって、人間の知能とは依然として謎に包まれ、議論の的となっています。

では、人工知能はどうなのか?

現在のAIは高度に専門化されています。たとえばチェスのプログラムはチェスに特化しており、化学に関するエッセイを書くことはできません。つまり、それぞれのAIは限られた分野内でのみ機能します。

これは「特化型AI(narrow AI)」と呼ばれます。ChatGPTのようなチャットボットは、大量の言語データで訓練されているため流暢な言葉を出力できますが、出力内容を理解しているわけではありません。この乖離が、現在のAIがAGIに到達できない理由となっています。

汎用人工知能(AGI)とは?

汎用人工知能にはさまざまな定義がありますが、共通する要素として、以下のようなものが挙げられます:

- 人間と同等かそれ以上の知能をもつ。

- 自律性と柔軟性を備えており、自らの判断で行動し、必要に応じてプロセスを適応させられる。

- 経験から学び、それを応用する高度な能力がある。

- 多領域にわたるタスクを遂行し、環境の変化に適応し、訓練されていない問題にも対応できる。

AGIのテスト

一部の専門家は、AIが汎用知能を達成するには常識的知能が必要だと主張していますが、それは非常に困難です。常識とは、日常の世界について人間が直感的・本能的に知っている事実のことです。つまり、物理的・社会的世界がどのように機能しているかの基本的な理解が必要です。

また、チューリングテストはもはや十分ではなく、代わりに、「コーヒーテスト」のような試験が求められています。これは「平均的なアメリカの家庭に入り、コーヒーを淹れる方法を自力で理解し、必要なものを見つけ、操作して淹れることができるかどうか」を問うものです。

AGIがこのようなテストを通過するには、「具現性(embodiment)」と「埋め込み性(embeddedness)」が必要です。これらの用語は、物理的かつ社会文化的な世界への統合を意味し、高い文脈的認識能力を要します。視覚的・空間的な認識、物の意味と機能、それらの使い方や相互作用の理解など、多くの要素が含まれます。

これらのテストが示すのは、人間にとって直感的で根本的な知能は、AIにとってはチェスの達人にするよりもずっと難しいということです。すでに、技術的な問題から、より哲学的・価値観主導の議論へと移行しつつあります。

機械は知的になれるのか?

AGIの実現には、きわめて技術的な科学分野と、人間の知性や意識に関する古くからの哲学的議論との対話が必要です。古代ギリシャの哲学者たちが議論してきた概念を再評価すること、そしてAIの能力と同じくらい、私たち自身についても省察が必要になります。

ただし、そもそも「私たちは正しい問いを立てているのか?」という疑問も出てきます。知性の定義は、何千年ものあいだ思想家たちを悩ませてきました。これは、MDPIのジャーナル『Computer Sciences and Maths Forum』に掲載されたある論考で探究されているテーマでもあります。彼らは、3つの哲学的アプローチを用いて、「AIは本当に知的か」という考えに異議を唱えています。

著者たちは、ChatGPTのような大規模言語モデルが、AGIに対する期待の方向性を決めてしまっていると考えています。つまり、私たちと洗練された言語でやりとりできる高機能な機械です。

しかし彼らは、「AIは知的ではない」と主張します。AIツールはアルゴリズムに基づいています。アルゴリズムは厳密で決定論的であり、非常に複雑な変数を含みながらも「もしXならYを行う」というif x, perform yのような構造を持っています。人間が設計したアルゴリズムに深く根ざしているため、自律的に意味のある情報を生み出すことはできず、それゆえ知的とは言えないというのです。

この議論の出発点は、「私たちがAIを擬人化しすぎている」という問題です。つまり、AIに人間の特徴を与えすぎているのです。しかし、人間に適用するような用語をAIにも適用する場合、意味合いは異なります。

たとえば、人間の「自律性」は行動の自由だけでなく、道徳や感情、そして責任といった要素を含みます。一方、機械における「自律性」とは、人間の設計者が構築したルールと秩序に従って独立して作動することです。

結局のところ、AIは人間の知能を「再現」しているのではなく、「模倣」しているにすぎないという結論に戻ってきます。

汎用人工知能に関する懸念

これらの議論の妥当性はさておき、あるいは同意するかどうかに関係なく、これらは人間とAIの「知性」という概念にまつわる曖昧さを反映しています。さらに、私たちに定義を明確にし、知性に関する理解の未完成さと向き合うことを求めます。たとえば、人間の神経回路とAIのアルゴリズムはどれだけ異なるのでしょうか?

この曖昧さを前提にすれば、AGIに関する懸念は哲学的なものから実践的なものへと移行できます。では、AGIに関する主な実務的な懸念とは何でしょうか?

自己プログラミング

AGIの定義に関係なく、AGIを引き起こす可能性のある決定的な出来事は、「自己プログラミング」または「自己改善型AI」です。これは、AIが強化学習における人間の関与を必要とせず、自らのアルゴリズムを改良していくことを意味します。

AIへの恐怖の多くは、このシナリオに根ざしています。これは「ペーパークリップのパラドックス」として有名に語られています。こうした黙示録的な懸念は、AIに対するガードレール技術の開発や国際的なAI規制の導入といった、多くの実務的な取り組みを見落としがちです。

バイアスと誤り

AIは誤情報の拡散を招く可能性があります。

2020年には、英国のパスポート写真チェックAIが、黒人女性に対して白人男性の2倍以上の確率で「規定に合わない」と判定していたことが明らかになりました。

この事例は、どれほど訓練やチェックを行っても、長年の人種的バイアスがAIに残る可能性を示しています。差別はデータの分類や評価方法に組み込まれ、機械にも反映され得ます。

2018年には、自動運転のUber車両が、自転車を押して道路を渡っていた女性を死亡させる事故が発生しました。AIは、横断中の歩行者や自転車に乗った人を認識するよう訓練されていましたが、「自転車を押しながら横断する人」を認識する訓練はされていなかったのです。これは「エッジケース」と呼ばれる、訓練データで十分に表現されない状況のことです。

これら2例は、AIがバイアスや誤りを内包しうること、また、訓練不足によってすでに現実に危険が発生していることを示しています。

汎用人工知能を再考する

AGIに関する議論は、しばしば哲学的になります。これは、人間の知能という概念自体が捉えどころのないものであるためです。AIは人間の知性を模倣しているにすぎず、再現しているわけではないため、私たちはしばしばAIの実力ではなく、抽象的な思索に迷いがちになります。

現時点では、ChatGPTのようなツールはAGIではありません。その能力は特定のタスクに限定され、どれほど範囲が広くとも領域外の理解や行動はできません。

AGIの要件を満たすには、自己プログラミング能力や、コーヒーテストのようなテストで測定される文脈的認識の獲得が必要です。AGIの実現可能性を評価するためには、こうした実用的で測定可能な要素に焦点を当てることが重要です。

AI研究

バイアスへの対処や、AIが私たちの生産性と関与を高める方向で活用されることが、ペーパークリップ問題のような終末論的なシナリオに対抗する鍵となるかもしれません。

MDPIでは、AIの能力を探究し、それを私たちの利益のために安全に活用することに強い関心をもっています。MDPIはすべての研究を即時に世界中に公開しており、すべての読者がすべての論文の本文に無料で無制限にアクセスできます。オープンアクセスは、AIの共同的かつ安全な発展を実現するために不可欠です。

※本記事はMDPIの英語ブログを元に作成したものです。元記事はこちら。